Robots.txt文件告诉搜索引擎哪些网页可以在您的网站上访问和编制索引,哪些网页不适用。例如,如果网站Robots.txt文件中指定不希望搜索引擎能够访问您的某个页面,那么该页面将无法显示在搜索结果中,无法找到它。保持搜索引擎访问您网站上的某些页面对您的网站隐私和搜索引擎优化至关重要。本文将解释这是为什么,并为您提供如何设置一个好的Robots.txt文件的知识。

Robots.txt如何工作

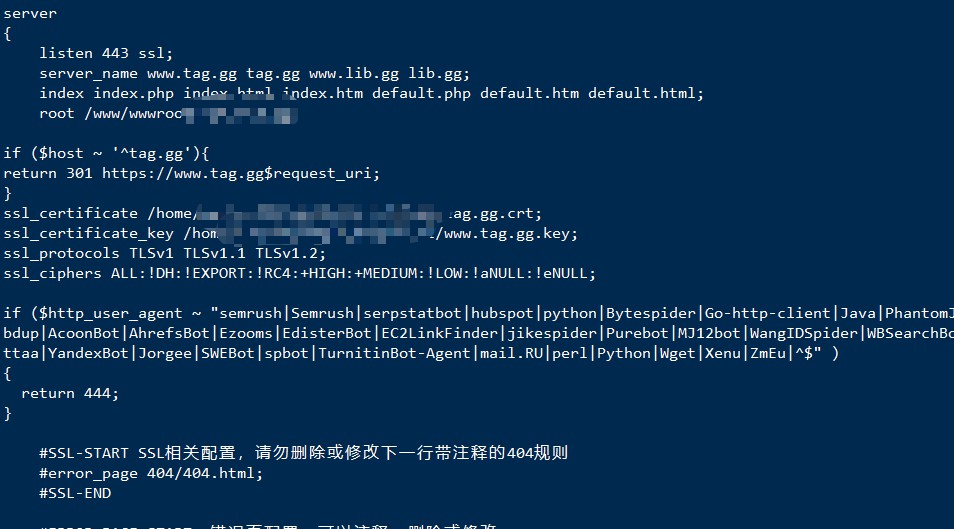

搜索引擎会发送名为“蜘蛛”或“机器人”的小程序来搜索您的网站,并将信息带回搜索引擎,以便您网站的网页可以在搜索结果中编入索引,并由网络用户找到。您的Robots.txt文件指示这些程序不要使用“禁止”命令来搜索您指定的网站上的页面。例如,下面的Robots.txt命令:

User-agent: *(用户代理 *)

Disallow:(不允许)阻止所有搜索引擎机器人访问您网站上的某个页面。

为什么有些页面需要被阻止

有两个原因可能导致您想要使用Robots.txt文件阻止页面。如果您的网站上有一个与另一个网页相同的网页,您不希望机器人将其编入索引,因为这会导致重复的内容损害您的搜索引擎优化。第二个原因是,如果您的网站上有一个页面,您不希望用户能够访问它,除非他们采取了特定的操作。例如,网站后台,你想阻止页面或文件是保护你的网站中的私人文件,防止安全隐患。

安装您的Robots.txt文件

一旦你有了你的Robots.txt文件,你可以将它上传到你网站主目录(www)。使用FTP程序来完成此操作。创建并安装robots.txt文件。

结论

如果您向网站添加页面,文件或目录,而您不希望被搜索引擎编入索引或被网络用户访问,则更新您的Robots.txt文件非常重要。这将确保您的网站的安全和您的搜索引擎优化的最佳结果。

文章评论 本文章有个评论