核心提示:链接难免遇到垃圾信息。Spammer 们用来推广站点垃圾,一些老CMS 系统中发现漏洞将垃圾信息注入受害者网站。

在好莱坞如果你被狗仔队盯上上,说明你是成功的,在硅谷,如果你被垃圾信息盯上,也说明你是成功的。周三上午,在 Web 2.0 峰会( Web 2.0 Summit),来自 Google, Reddit, Pramana 以及 Wikipedia 的代表畅谈了如何抵制垃圾信息。

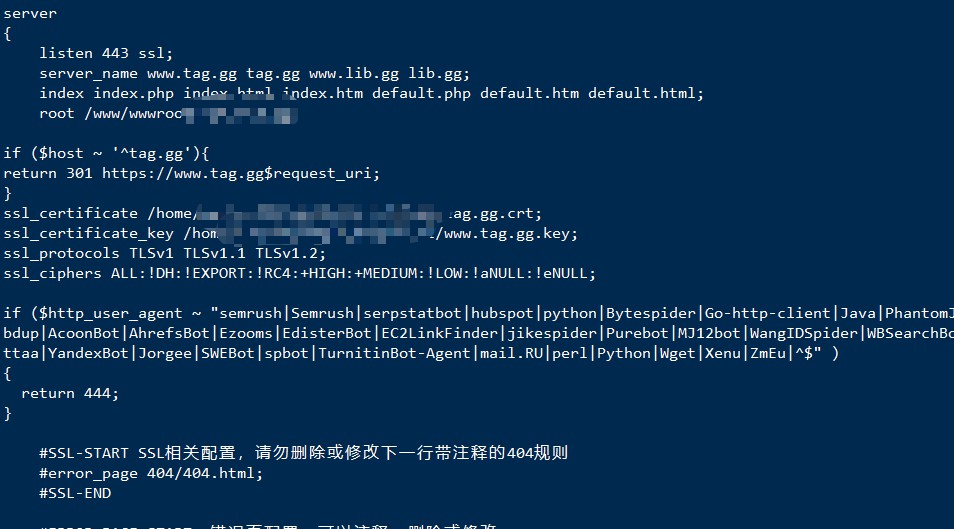

Google 的反垃圾信息团队的主管 Matt Cutts 说,如果你提供链接相关的服务,就难免遇到垃圾信息。Cutts 谈到了3种类型的垃圾信息,Spammer 们用来推广站点的垃圾链接;向那些允许用户提供反馈的网页提交垃圾内容;从一些老的 CMS 系统中发现漏洞将垃圾信息注入受害者网站。

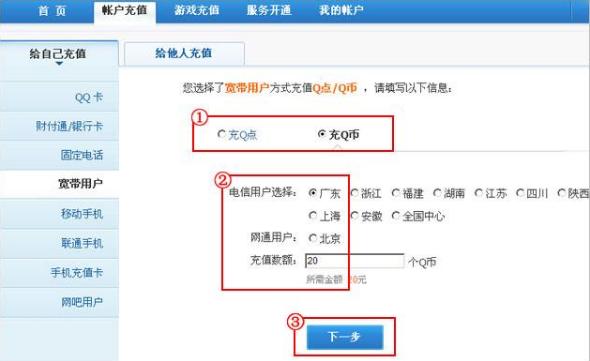

针对垃圾信息,Cutts 建议使用 Akismet 一类的信息过滤服务,部署 CAPTCHA,勤打补丁,甚至对注册收费等手段进行应对。他建议人们跳出思维圈子,使用一些意料不到的方式对付垃圾信息。如果你让垃圾信息发布者产生挫败感,比向他们收费还有效。

Reddit 的创始人 Steve Huffman 谈到了他们使用的一些方法,对垃圾信息发送者进行误导。他表示,Reddit 是一种类似 Digg 但比 Digg 更好的服务,Digg 允许用户提交他们喜欢的内容的链接,并对发布的内容进行投票,获得投票数越多的内容被阅读的几率越大。

但 Reddit 有所不同,在 Reddit,有些投票不被计算。一旦 Reddit 探测出某人是在发送垃圾信息,他的帐户会被抵制,但 Reddit 不会通知发垃圾信息的人,他的提交还正常进行,但他提交的内容不会发布。Huffman 表示,我们使用一些技巧让垃圾信息发送者以为他们的伎俩得逞。

Jonathan Hochman 是 Wikipedia 的管理员,他谈到了 Wikipedia 应对垃圾信息和蓄意破坏时使用的一些策略。他说,我们花费了很多时间让 Wikipedia 保持干净。Wikipedia 中 20% 到 30% 的编辑操作是蓄意破坏以及对蓄意破坏的修复。

Wikipedia 是一个允许任何人参与编纂的在线百科全书,但少为人知的是,这个站点依靠的是计算机自动编辑,Hochman 解释道,一些自动程序参与了编辑工作。

比如 ClueBot,它参与了大约80万篇文章的编辑,ClueBot 做了大量文章复原与修复工作,如果有人不断地对某个页面进行破坏,它会通知人进行干预。

Praman 的 CEO Sanjay Sehgal 则讲述了他们的 HumanPresent 技术,该技术用来保护他们刚刚发布的,尚未命名的海量玩家游戏,他说,CAPTCHA 不起作用,因为很容易被破解。

Pramana 的技术会尝试辨别真正的用户与自动程序。一个游戏中有太多机器人玩家会让游戏崩溃。这个技术不仅仅用于阻止 Spam,还帮助改善用户体验,提供流量数据。自从使用了 HumanPresent 技术,Pramana 发现 12% 到 15% 的流量来自机器人程序。

来源:informationweek.com 翻译:COMSHARP CMS (锐商企业CMS)官方网站

文章评论 本文章有个评论