核心提示: 在一个网站里,robots.txt是一个重要的文件,每个网站都应当有一个设置正确的robots.txt。

当搜索引擎来抓取你的网站文件之前,它们会先来看看你网站的robots.txt文件的设置,以了解你所允许它抓取的范围,包括哪些文件,哪些目录。那么如何配置您的robots.txt文件呢?

让我们看一个例子:

# robots.txt file start

# Exclude Files From All Robots:

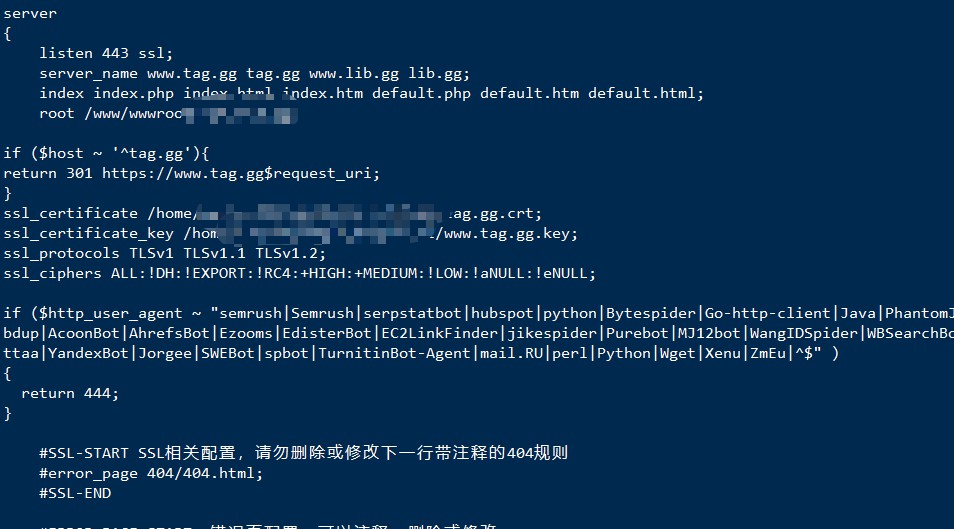

User-agent: *

Disallow: /admin_login/

Disallow: /admin/

Disallow: /admin.htm

Disallow:/admin.aspx

# End robots.txt file

有#号的都是注释,方便阅读。

User-agent就是搜索引擎的蜘蛛,后面用了*号,表示对所有的蜘蛛有效。

Disallow就是表示不允许抓取,后面的目录或者文件,表示禁止抓取的范围。

编辑好这个文件,然后保存在你的网站的根目录下(一定是根目录下,当然你也可以调整),那么搜索引擎就会来看的。

如果你没有robots.txt文件,在你的网站访问日志文件里,你会看到蜘蛛访问robots.txt文件不成功的纪录。

好了,现在就去设置你的robots.txt文件吧。

亲爱的:被墙域名跳转TG:@qianhenetwork QQ:851617266,可否收藏+评论+分享呢?

文章评论 本文章有个评论